Vào thứ Sáu, trong ngày thứ 12 của sự kiện "12 ngày của OpenAI", CEO Sam Altman đã công bố các mô hình "suy luận" AI mới nhất của công ty, o3 và o3-mini, được xây dựng dựa trên các mô hình o1 ra mắt đầu năm nay. Mặc dù chưa phát hành rộng rãi, nhưng OpenAI sẽ cung cấp quyền truy cập vào các mô hình này cho các nhà nghiên cứu an toàn và thử nghiệm từ hôm nay.

Các mô hình sử dụng công nghệ mà OpenAI gọi là "chuỗi suy nghĩ riêng tư", cho phép mô hình tạm dừng để kiểm tra cuộc đối thoại nội bộ và lên kế hoạch trước khi đưa ra phản hồi. Đây có thể được gọi là "suy luận mô phỏng" (SR) - một dạng AI vượt xa các mô hình ngôn ngữ lớn (LLM) cơ bản.

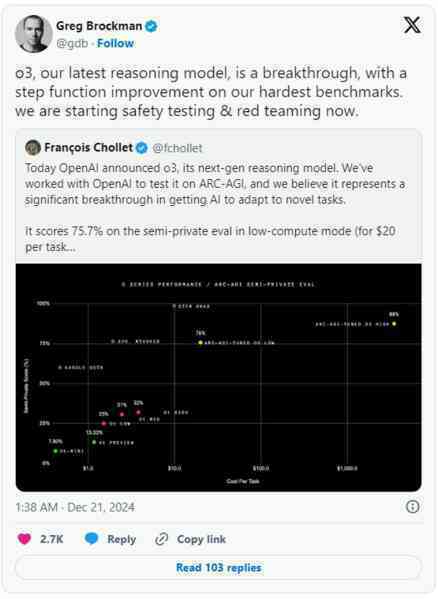

Theo OpenAI, mô hình o3 đạt được điểm số kỷ lục trong bài kiểm tra ARC-AGI, một thước đo lý luận trực quan chưa từng bị đánh bại kể từ khi ra đời vào năm 2019. Trong các tình huống tính toán thấp, o3 đạt 75,7%, trong khi với tính toán cao, nó đạt 87,5% - tương đương với hiệu suất của con người ở ngưỡng 85%.

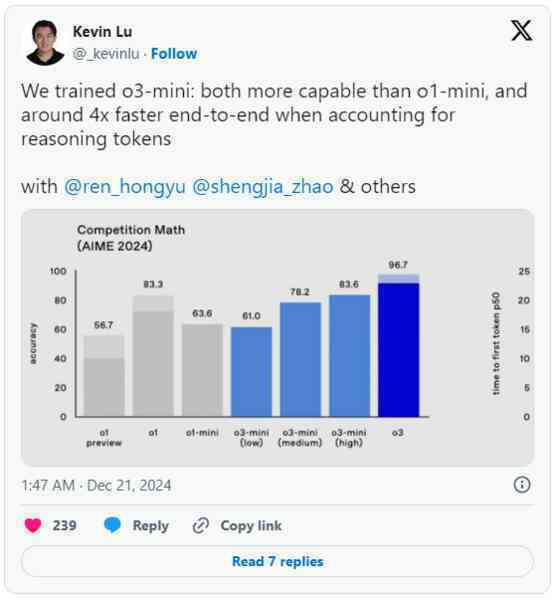

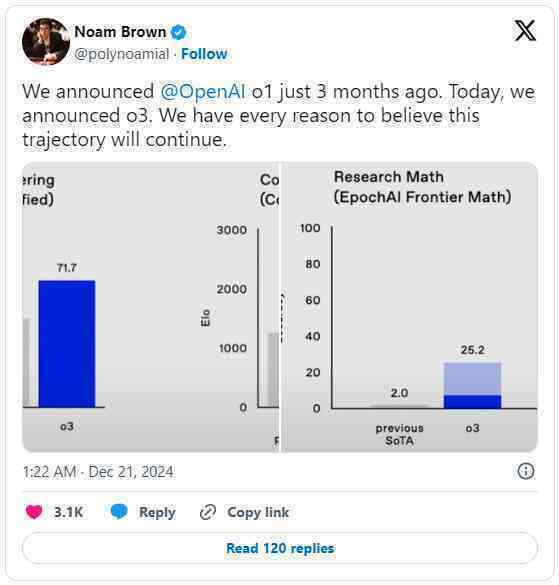

OpenAI cũng cho biết o3 đạt 96,7% trong Kỳ thi Toán học Mời của Mỹ năm 2024, chỉ bỏ lỡ một câu hỏi. Mô hình này cũng đạt 87,7% trên GPQA Diamond, bao gồm các câu hỏi về sinh học, vật lý và hóa học ở trình độ sau đại học. Trên bài kiểm tra Frontier Math của EpochAI, o3 giải được 25,2% bài toán, trong khi không có mô hình nào khác vượt quá 2%.

Các phép đo cho thấy mô hình o3 mới của OpenAI đang tiến gần hơn tới AGI

Biến thể o3-mini, cũng được công bố vào thứ Sáu, bao gồm tính năng thời gian suy nghĩ thích ứng, cung cấp các tốc độ xử lý thấp, trung bình và cao. Công ty cho biết các cài đặt tính toán cao hơn sẽ cho kết quả tốt hơn. OpenAI báo cáo rằng o3-mini vượt trội hơn người tiền nhiệm o1 trong bài kiểm tra Codeforces.

Thông báo của OpenAI đến khi các công ty khác cũng đang phát triển các mô hình SR của riêng mình, bao gồm Google với Gemini 2.0 Flash Thinking Experimental ra mắt vào thứ Năm. Trong tháng 11, DeepSeek cũng tung ra DeepSeek-R1, trong khi nhóm Qwen của Alibaba phát hành QwQ - cái mà họ gọi là phiên bản thay thế "mở" đầu tiên cho o1.

Các mô hình AI mới này dựa trên các LLM truyền thống, nhưng có một sự khác biệt: Chúng được tinh chỉnh để tạo ra một loại quá trình suy nghĩ lặp đi lặp lại có thể xem xét kết quả của chính nó, mô phỏng lý luận theo cách gần như vét cạn và có thể mở rộng quy mô tại thời điểm suy luận, thay vì chỉ tập trung vào việc cải thiện trong quá trình huấn luyện mô hình AI.

OpenAI sẽ cung cấp các mô hình SR mới cho các nhà nghiên cứu an toàn để thử nghiệm trước. Altman cho biết công ty dự kiến sẽ ra mắt o3-mini vào cuối tháng 1, và o3 sẽ theo sau ngay sau đó.

OpenAI đang cho thấy năng lực nghiên cứu và phát triển các mô hình AI vượt trội so với đối thủ

Một số điểm đáng chú ý về khả năng của mô hình o3:

- Điều chỉnh thời gian suy luận: Các mô hình có thể được thiết lập ở mức tính toán thấp, trung bình hoặc cao, tương ứng với thời gian "suy nghĩ". Tính toán càng cao, o3 càng hoạt động tốt hơn.

- Điểm số cao trên các bài kiểm tra như ARC-AGI (87,5%), Kỳ thi Toán học Mời của Mỹ (96,7%), GPQA Diamond (87,7%) và Frontier Math (25,2%), vượt xa các mô hình khác. Tuy nhiên, các tuyên bố này cần được xác thực bởi các đánh giá từ bên ngoài.

- Khả năng tự kiểm tra và sửa lỗi, giúp tránh một số sai sót thường gặp ở các mô hình AI khác. Tuy nhiên, o3 vẫn có thể mắc lỗi.

Một số ý kiến cho rằng o3 có thể đang tiến gần hơn tới Trí tuệ Nhân tạo Tổng quát (AGI) - loại AI có thể thực hiện bất kỳ nhiệm vụ nào mà con người có thể. Tuy nhiên, chuyên gia François Chollet, đồng sáng lập bài kiểm tra ARC-AGI, lưu ý rằng o3 vẫn thất bại trong một số tác vụ rất dễ và có sự khác biệt cơ bản so với trí thông minh của con người. Ông cũng cảnh báo không nên sử dụng ARC-AGI như một thước đo siêu trí tuệ nhân tạo.

Dù các tuyên bố của OpenAI cần được xác minh thêm, sự xuất hiện của o3 cho thấy xu hướng phát triển mạnh mẽ của các mô hình AI lý luận. Nhiều công ty đang chuyển hướng sang phương pháp này trong bối cảnh các kỹ thuật gia tăng quy mô mô hình truyền thống không còn mang lại nhiều cải tiến. Tuy nhiên, một số chuyên gia nghi ngờ liệu các mô hình lý luận có phải con đường tối ưu trong tương lai, khi chúng đòi hỏi nguồn lực tính toán lớn và chưa rõ khả năng duy trì tốc độ phát triển.

Việc OpenAI ra mắt o3 đồng thời với sự ra đi của nhà khoa học tài năng Alec Radford cũng là một điểm đáng chú ý. Radford, tác giả chính của bài báo học thuật khởi đầu cho loạt mô hình AI "GPT" của OpenAI, đã quyết định rời công ty để theo đuổi nghiên cứu độc lập.

Lấy link